企業の生成系AI利用におけるセキュリティリスクと情報漏洩対策

-

│

1. はじめに

Chat GPTは、アメリカのOpen AI社が開発したAI(人工知能)によるチャットサービスです。

2022年11月にリリースされたChat GPTは、わずか2ヶ月弱で1億以上のユーザーを獲得し、マイクロソフト社から1兆円を超える

投資を受けるなど、多大な注目を浴びています。

しかし、利用者が増加するにつれて、情報漏洩などセキュリティリスクも懸念されています。

Chat GPTなどの生成系AIはユーザーからの回答データを蓄積するため、機密情報や社内情報を入力してしまうと、AIが学習し別のユーザーに対して機密情報を回答することで、情報漏洩に繋がってしまうからです。

この記事では、Chat GPTなどの生成系AIのセキュリティリスクを説明するとともに、SSE製品(Netskope)を

利用した情報漏洩対策を紹介します。

目次

- はじめに

- Chat GPTの導入と情報漏洩のリスク

- 企業の一般的な情報漏洩対策

- SSE製品による新たな対策、さらに情報漏洩を防ぐためには

- まとめ

2. ChatGPTの導入と情報漏洩のリスク

生成系AIの導入

業務の効率化や生産性向上を目的として、様々な企業や政府などで生成系AIの導入が始まっています。

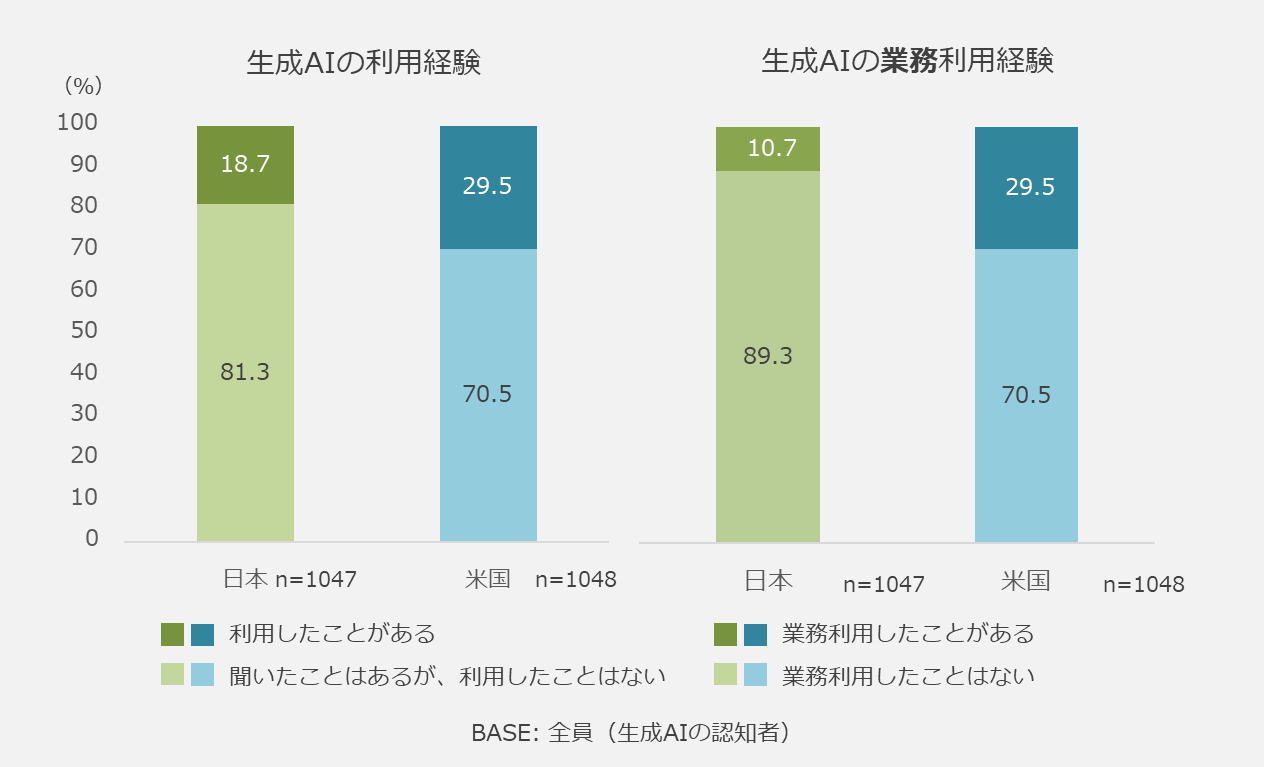

2023年10月時点で、GMOリサーチ株式会社が生成系AIの業務利用経験について調査をしたところ、

生成系AIを認知している人の内、既に業務利用経験のある人は、日本では10.7%になっています。

米国では29.5%となっており、今後も日本での生成AIの活用が進んでいくことが想定されます。

【調査概要】

調査タイトル:生成AIの利用実態・意識に関する調査

調査対象: 生成AIについて認知している20歳~69歳の正社員

調査期間:2023年8月9日~8月18日

調査方法:インターネット調査

調査主体:GMOリサーチ株式会社

リンク : https://gmo-research.jp/pressroom/survey/voluntary-survey-20231013

例えば製造業では、開発などの業務において、ドキュメント作成やプログラムコード作成などで導入が進んでいくことが考えられます。

生成系AIを使用することによって、実装したい処理の流れや使用する言語などを含めて入力する文章を作成すると、

簡単に要件を満たしたプログラムコードを出力させることができます。

他にも金融・保険などのサービス業では、文章の要約や添削、社内会議の議事録の作成などで活用している例が考えられます。

以前から、添削についてはWordの校正の機能などがありましたが、生成系AIを利用することで、

文章の校正や添削、要約作成など、時短かつ精度を上げてアウトプットすることができるようになってきています。

このように生成系AIは、様々な企業のビジネスシーンで広く活用される有意義なツールとなっていくと想定されます。

Chat GPTの情報漏洩リスク

生成系AIは、即座な反応ができ、生産性を向上できる反面、様々なリスクが懸念されています。

リスクの例を3つ取り上げます。

情報漏洩

生成系AIでは、ユーザーからの回答データは全てクラウド上で保管されています。そのため、ユーザーが企業の機密情報や

重要情報を一度でも入力してしまった場合、クラウド上から削除できず、重要な情報が流出する危険性が残り続けます。

フィッシング詐欺

生成系AIで偽メールや文言を作成し、金銭をだまし取るといったことも可能性として考えられます。

今までは、攻撃者がフィッシングメールの文面を作成する場合、日本語をネイティブとして扱える必要がありました。

外国人が作ったフィッシングメールの日本語は不自然で気が付きやすかったですが、生成系AIを利用することで

自然な日本語のフィッシングメールが簡単に作れるようになります。生成系AIで作成されたメールによって、

フィッシング詐欺のメールであるかどうかの判別を付けるのが、より困難な状況になってくるでしょう。

悪意のあるプログラミングコードの生成

生成系AIを使用して、悪意あるプログラミングコードが簡単に生成されるリスクがあります。

これまで一部の攻撃者のみが攻撃コードを作成できましたが、生成系AIを利用することで、技術知識の乏しい

攻撃者でも作成できるようになってしまいました。

生成系AIであるChat GPTを利用したセキュリティインシデントの例として、

2023年3月に韓国のサムスン電子社で情報漏洩が発生しています。

サムスン電子社では、2023年3月11日に、Chat GPTの利用を業務内で許可され、社内の利用ルールを周知していたにもかかわらず、

その後、わずか20日間のうちに3件の情報漏洩が発生しています。

参考 https://pc.watch.impress.co.jp/docs/news/yajiuma/1490904.html

セキュリティインシデントが発生してからの対応では遅いため、各企業で生成系AIのメリットだけでなく、

使用する上でのリスクを理解していただくことが非常に重要です。

そのため、今後生成系AIなどのChat GPTを業務上安全に利用するための仕組みづくりが非常に必要になっています。

3. 企業の一般的な情報漏洩対策

生成系AIを安心して利用するために、各企業で適切な業務利用ルール設定と管理が必要になります。

日本ディープラーニング協会では、生成系AIを利用するにあたってのガイドラインを作成し、一般に公開しています。

生成系AIの利用ガイドラインでは、「データ入力に際して注意すべき事項」と「生成物を利用するに際して注意すべき事項」の

2つのパートで構成されています。

●生成系AIにデータを入力する際に注意すべき事項

| (1) | 第三者が著作権を有しているデータ(他人が作成した文章など) |

| (2) | 登録商標・意匠(ロゴやデザイン) |

| (3) | 著名人の顔写真や氏名 |

| (4) | 個人情報 |

| (5) | 他社から秘密保持義務を課されて開示された秘密情報 |

| (6) | 自組織の機密情報 |

●生成系AIが作成した生成物を使用するに際して注意すべき事項

| (1) | 生成物の内容に虚偽が含まれている可能性がある |

| (2) | 生成物を利用する行為が誰かの既存の権利を侵害する可能性がある |

| (3) | 生成物について著作権が発生しない可能性がある |

| (4) | 生成物を商用利用できない可能性がある |

| (5) | 生成AIのポリシー上の制限に注意する |

引用元 : 日本ディープラーニング協会 / 生成AIの利用ガイドライン

このように生成系AIを利用している/利用を検討している企業は、上記の情報を参考に、独自のガイドラインを作成する必要があります。

しかし、このようなガイドラインの作成と従業員への周知・徹底を呼びかけることで情報漏洩対策は完璧と言えるでしょうか?

また、従業員の入れ替わりもある中で、常に全ての従業員がガイドラインの内容を正確に理解している状態にすることは

非常に難しくセキュリティリスクが0になることはありません。

セキュリティインシデントの事例でもあった通り、ガイドラインをよく読まず、リスクについて知らずに利用している人や

誤って機密情報を入れてしまう可能性がなくなることはありません。

では、どうしたらセキュリティリスクを0に近づけることができるでしょうか?

4.SSE製品による新たな対策、さらに情報漏洩を防ぐためには

セキュリティリスクを0に近づけるためには、ガイドラインの順守を徹底した上で、

「いつ」「どこから」「誰が」「どんな操作を」「どのくらいの頻度で」などの従業員の行動を可視化し、

継続的に監視していく必要があります。

継続的な監視、可視化は、SSE製品を導入することで実現ができます。

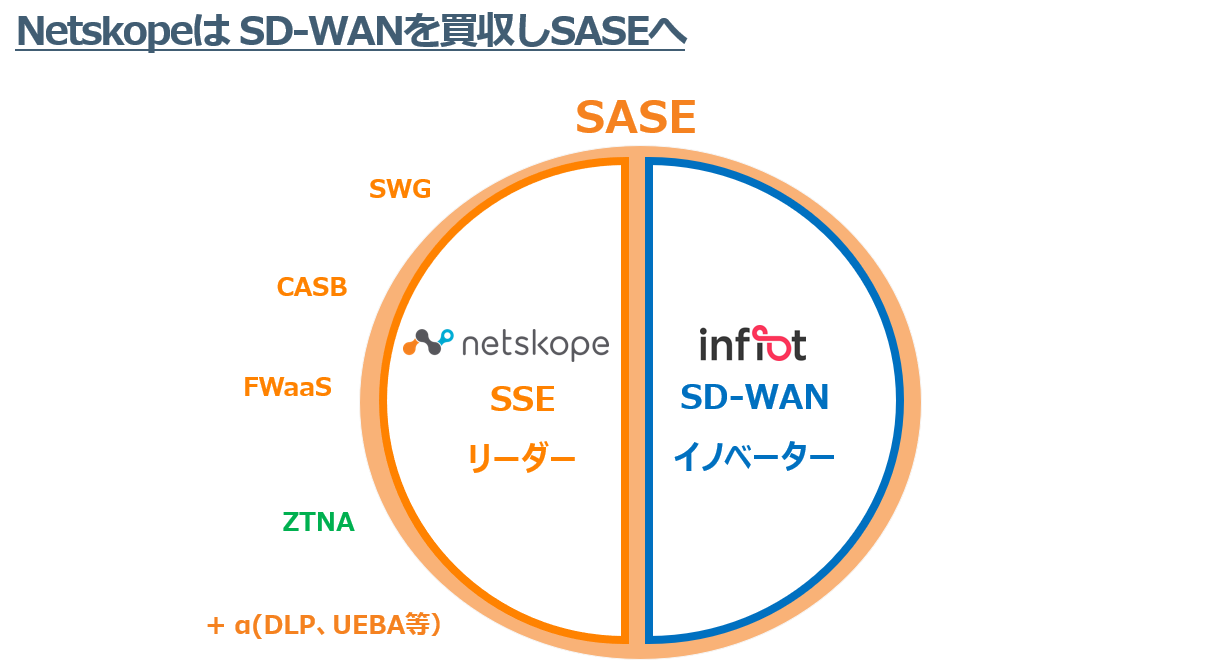

SSEとは、Security Service Edgeの略称で、SWG、CASB/DLP、ZTNA、FWaaS、RBIなどを組み合わせて、

単一のセキュリティサービスとして提供するものです。

SSEを導入することで、インターネット(ブラウザアクセス)、SaaS、特定の内部アプリケーションへの安全なアクセスを提供します。

弊社で取り扱っているNetskope製品を例に、具体的な情報漏洩対策の2つのポイントを見ていきましょう。

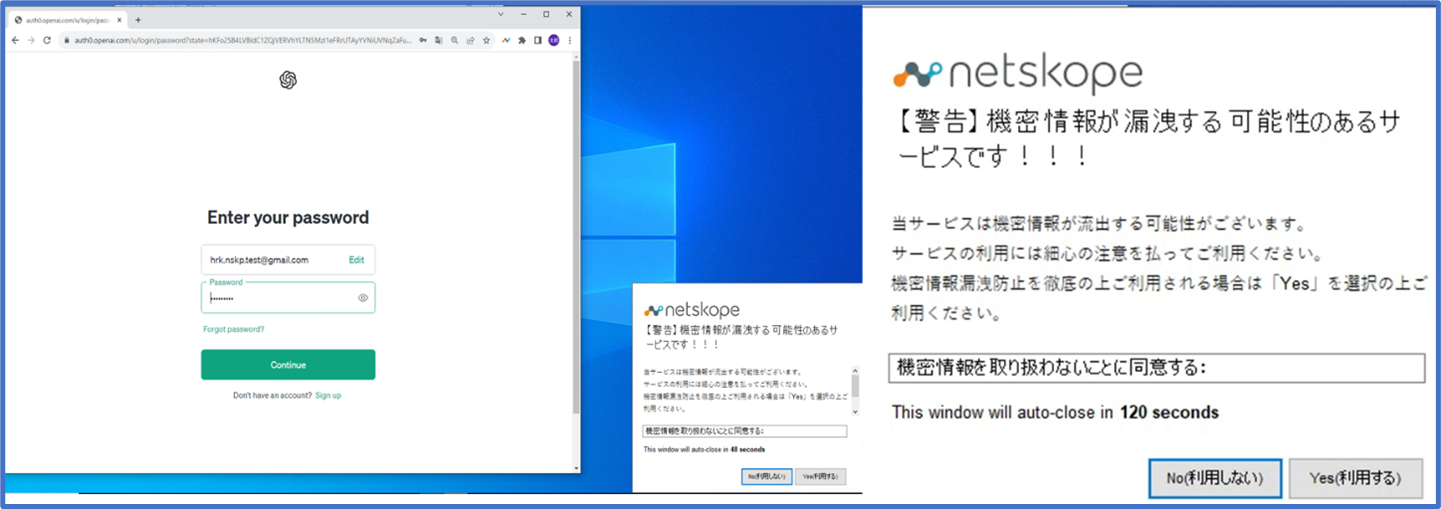

一つ目は、Chat GPTのようなSaaSアプリケーションにアクセスしているユーザーへの、リアルタイムでのユーザーコーチングです。

Chat GPTの利用を試みたユーザーに対して、機密データが漏洩する可能性のあるサービスであることの注意喚起を実施し、

利用を続けるか否かを問うポップアップを表示させます。

この機能によって、ユーザーが情報漏洩の危険性があるサービスであることを理解した上で、操作を続けるか判断することができます。このメッセージは管理者側で変更することがでい、例えば、各企業内で作成したガイドラインのリンクを案内することもできます。

下図(左 : 画面全体 右 : 警告画面拡大)は、実際に弊社環境にてChat GPTへログインを試みた際の警告画面です。

このように警告画面で、ログイン時にあらかじめ注意喚起を行うことで、機密情報を入力する可能性を下げることができます。

しかし、ユーザーコーチングをしてもなお、ユーザーが誤って機密情報や開発コードを入力する可能性は捨てきれません。

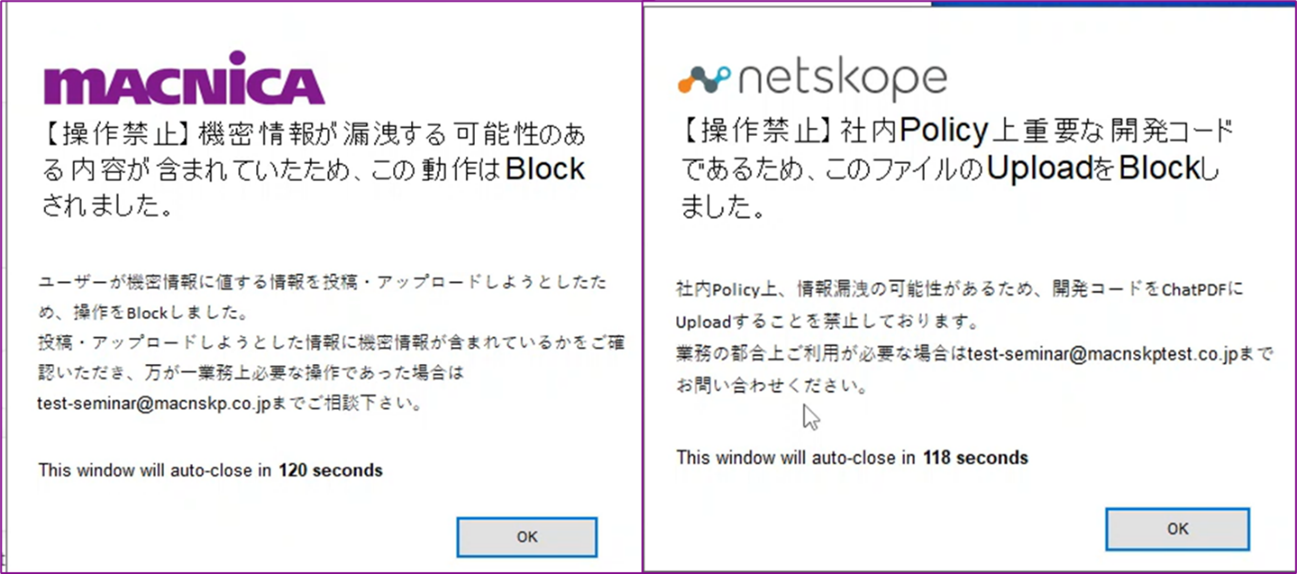

二つ目はセキュリティリスクを完全に排除するために、Chat GPTに入力されるデータに対するデータ保護(DLP)を使用します。

一つ目のユーザーコーチングとデータ保護(DLP)を組み合わせることで、Chat GPTの安全な利用を可能にします。

具体的には、ユーザーが機密情報や開発コードを入力した際に、Netskopeのデータ保護(DLP)の機能によって、

入力されたデータを確認し、必要に応じてブロックします。

下図は、実際にChat GPTに対して、機密情報やプログラミングコードを入力した際に、アップロードをブロックしている図になります。

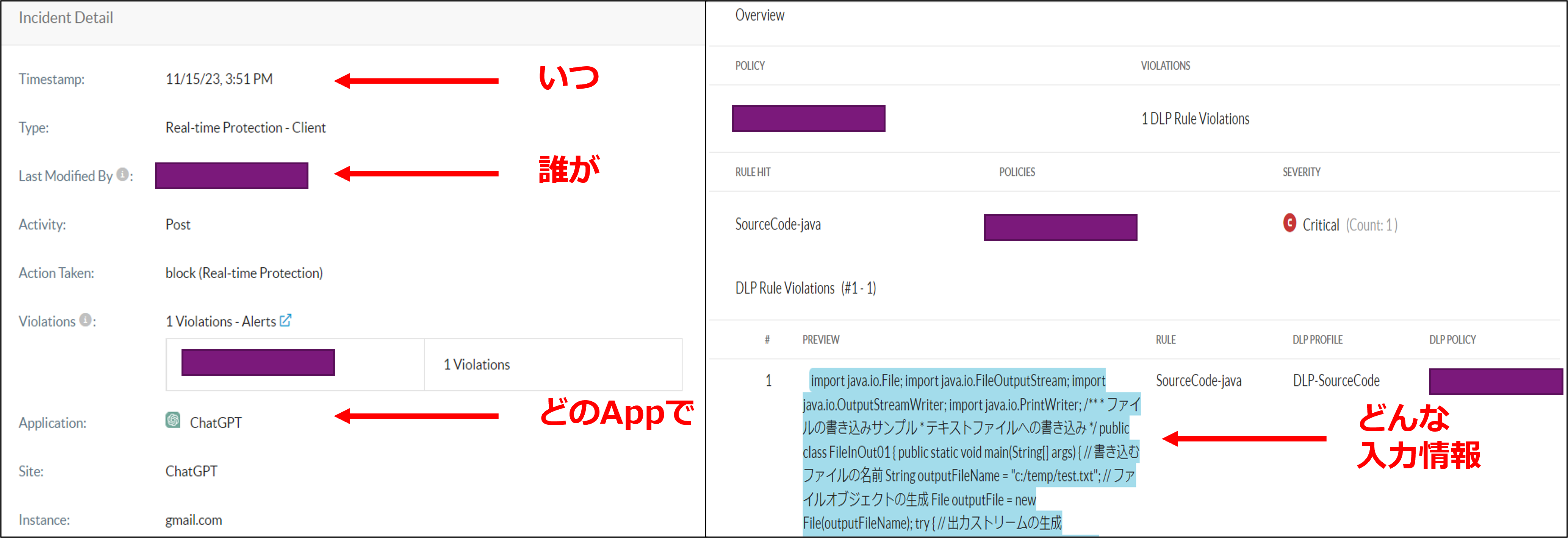

また、Netskope製品では可視化の機能として、フォレンジックの機能を持ち合わせているため、Chat GPTに機密情報を入力した場合、

「いつ」「誰」が「どんな入力情報」で検知したのかが、インシデントログとして出力されます。

下図のように、Netskopeの管理画面で表示されるログで、左上で「いつ」「誰が」「どのAppで」、右下で「どんな入力情報」で検知したかを把握することができます。

まとめると、一つ目のユーザーコーチングでは、生成系AIが情報漏洩する可能性のあるサービスであることを

ユーザへ周知し、二つ目のデータ保護(DLP)でガイドラインを遵守しても防ぎきれない部分を、データ保護(DLP)で守ることができます。

Netskope製品のようなSSE製品を使用することで、ユーザーを指導し、機密情報の入力については操作を禁止することが可能になり、生成系AIのセキュリティリスクを0に近づけることができます。

5. まとめ

生成系AIは働き方や生産性を向上させる可能性がある一方で、機密情報が抜き取られ、セキュリティリスクに繋がる恐れもあります。

今回お話ししたような対策を行うことで、生成系AIの恩恵をしっかりと受けつつ、"情報漏洩のリスクをなくすために必要なことは何か"を考えてみてはいかがでしょうか。

関連する資料・セミナー

クラウドにおけるデータ保護戦略の立て方 Netskopeによるデータ保護戦略

過去10年の間に、企業にとって最も強力なツールの1つとなった"データ"。継続的なリスク管理を実現するデータ保護の進化とは?

SASEアーキテクチャで描くゼロトラストの青写真 Netskopeで実現するゼロトラスト

ゼロトラストおよびSASEの導入に不可欠な要素である継続的なアダプティブトラストを採用するための鍵とその方法とは?

SASEのリーダー Netskope製品コンセプト

CASB、セキュアWebゲートウェイ、ゼロトラストネットワークアクセスをひとつのプラットフォーム上でネイティブに構築するNetskopeをご紹介。

【ウェビナー】ゼロトラストの5つの構成要素:アイデンティティ・デバイス・ネットワーク・データ・ワークロードをテーマにゼロトラWeekを開催!